首先,对“大数据”,不同的行业对其都有各自的理解,比如计算机领域更多的会探讨云存储、分布式数据库、分布式处理、分布式数据挖掘等等。而统计学家更看重的是大数据背后的因果关系,或者说对于大家对于社会的价值所在。

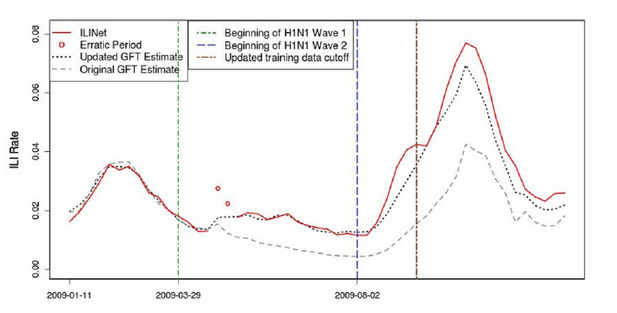

张俊妮教授首先通过“谷歌流感趋势”模型的介绍,让大家见识了大数据对于疾病防控的重大价值。谷歌作为全球最大的科技公司之一,其通过监控美国用户对于流感相关的检索词,以及相应的数量变化,准确的预测的2009年美国流感的发生情况。谷歌的工程师将他们的预测模型“GoogleFlu Trends”发表在了“自然”杂志,引起了也业界媒体的大量关注。然而,即使谷歌如此前沿的公司,他们的模型也并不完美。在接下来的两年,谷歌的流感预测模型严重低估了流感的数量,虽然谷歌作了修正,但在2013年的流感预测中模型又严重高估了流感数量。大数据公司虽然能收集到数量庞大的各种数据,但如果要让这些数据显现出它们的价值,仅仅只有数据是肯定不够的。

接下来张俊妮教授通过一些有趣但是错误的科研结论(比如一项研究表明,14岁以下的孩子手臂越长其IQ越高,显然这个结论是有问题的),让大家明白,很多大数据的模型或结论之所有出现严重偏差,最主要的原因就是没有弄清楚相关性和因果性的区别,也可以说一些研究人员在对研究项目理解不足的情况就进行数据建模,最后导致得出的结论让人大跌眼镜。

与业务理解不足同样存在的问题是抽样偏差。抽样偏差从统计学存在以来就一直伴随其左右。即使我们的科技飞速发展,采集数据的效率和方式越来越丰富,但我们很多情况下也只能采集到研究群体的部分数据,而数据的不完整就很有可能无法反映整个群体的特征。“失之毫厘,差之千里”形容的就是这个问题,一个小小的数据缺失,通过模型的放大,最后得出来的结果可能与实际情况千差万别。一个好的统计模型一定得很好的解决好这两个问题,得出来的结论才比较准确。

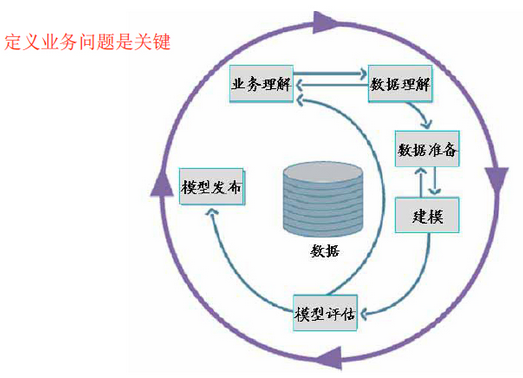

张俊妮教授向我们介绍了一个常用的数据挖掘方法论:Cross-IndustryStandard Process for Data Mining

中国海关就曾使用这套建模方法建立了海关执法评估系统。通过模型,国家海关在宏观层面能准确的预测税收(准确率达到了99.68%),在中观层面能更合理的根据各海关情况评估其运转效率,在微观层面能有效监测货物的异常波动。因此,通过正确的方法建立数据挖掘模型,能很好的帮助我们作出各个层面的决策。

为了能更直观的向大家说明抽样偏差的问题,张教授引用了一个大型在线游戏的建模案例。在这个案例中,研究人员希望了解有无朋友对于玩家登录游戏的次数以及消费所影响的程度。通过传统的统计方法,简单将有朋友和没有朋友的玩家分成两组,得出的结论中,有朋友的玩家比没有朋友的玩家在登录和消费上分别高出22.35%和7.1%。然而,通过这种简单的分组可能会存在严重的抽样偏差。因为一个玩家是否登录和消费经常受很多其他因素的影响,如果单纯的只考虑有无朋友这一个因素,将有可能忽略掉其他因素的营销,所以更好的统计方法需要使用到Rubin因果模型来对样本进行修正。通过修正其余的16项因素(比如性别、是否参加行会、是否玩过PVP等等),让其他因素的影响达到最小化。通过新的方法,模型得出的结论是有朋友的玩家比没有朋友的玩家在登录和消费上高出7.7%和1.51%,这大大低于之前通过简单对照的结论。

由于张教授带来的课程都是通过一些实际的案例为大家一一解释大数据在统计学中的奥妙,接近2个小时的演讲一眨眼功夫就过去了,很多同学意犹未尽,带着各种各样的问题来询问老师。

参加完这次培训,小编深深的觉得作为营销人的我们,学习和了解统计学的知识是必不可少的一项基本功,特别是在这个大数据时代,通过统计学的数据挖掘方法能够更深刻的为我们揭示“大数据”背后的价值,为行业带来更深刻的洞察。在接下来的日子里,360营销学苑会继续为广大学员们邀请业内专家,希望能够为大家在工作之余提供一些“脑力营养品”。